Oto jeden niepodważalny fakt: w ciągu ostatnich kilku lat na rynku laptopów PC sprzedano więcej niż komputery stacjonarne. Jest to nieunikniony efekt uboczny rewolucji mobilnej, w wyniku której dzisiaj żyjemy w świecie, w którym użytkownicy komputerów nie chcą już być „zakotwiczeni” w jednym miejscu. Zamiast tego chcą używać ich w ruchu, w dowolnym miejscu i czasie, jak chcą..

W przypadku większości nowoczesnych modeli nie stanowi to problemu - nowoczesne konfiguracje laptopów zapewniają błyskawiczną prędkość w takich przypadkach użytkowania, jak surfowanie po Internecie, praca z aplikacjami biurowymi, oglądanie filmów i słuchanie muzyki.

W przypadku gier sytuacja wygląda jednak nieco inaczej. Tradycyjnie są one jednym z najbardziej „zachłannych” zasobów sprzętowych aplikacji komputerowych, stawiając niezwykle wysokie wymagania względem cech systemu. A ponieważ współczesne technologie mobilne nadal wymagają pewnego poziomu kompromisu między wydajnością a energooszczędnością, nawet najbardziej wydajny (i drogi) laptop klasy do gier nie może zapewnić poziomu wydajności komputera stacjonarnego wyposażonego w komponenty najnowszej generacji.

Ale może to już przeszłość dzięki bardzo interesującej technologii o nazwie Adaptive Sync. W tym celu musimy podziękować firmie NVIDIA, która, choć nie można jej nazwać jej twórcą, wniosła największy wkład w komercjalizację tej technologii..

Z jego pomocą już wkrótce laptopy do gier będą mogły oferować wrażenia w grach porównywalne pod względem jakości do ich odpowiedników na komputerach stacjonarnych, bez decydujących kompromisów w zakresie wydajności energetycznej.

Synchronizacja klatek i dlaczego jest to problem dla graczy?

Jeśli czytasz materiały omawiające wydajność gry w określonej konfiguracji, prawdopodobnie zauważyłeś, że autorzy często odnoszą się do jednego określonego wskaźnika - 60 klatek na sekundę. Dla większości graczy cenione 60 klatek na sekundę jest rodzajem „Świętego Graala” wysokiej jakości gier komputerowych, ale nie jest to związane ze sprzętem komputerowym, ale z cechami współczesnych wyświetlaczy LCD.

Obecnie większość wyświetlaczy, szczególnie tych wyposażonych w komputery mobilne, używa stałej częstotliwości odświeżania. Jest to jeden z kluczowych wskaźników każdego monitora, który wskazuje, ile razy na sekundę wyświetlany na nim obraz jest aktualizowany..

Kolejny parametr, który już odnosi się bezpośrednio do karty graficznej, znany jest jako „Klatki na sekundę” (klatki na sekundę lub tylko fps), a jego nazwa mówi sama za siebie: jest to liczba klatek gry, które można zapewnić w odpowiedniej konfiguracji, aby stworzyć realistyczną iluzję ruchu.

Aby uzyskać maksymalne wrażenia z gry, te dwa wskaźniki muszą być zsynchronizowane - tj. sprzęt komputerowy powinien zapewniać 60 klatek na sekundę, które monitor będzie wizualizować z częstotliwością odświeżania 60 Hz. W tym idealnym przypadku na ekranie zobaczysz obraz, który będzie gładki, bez migotania, rozdarcia lub rozmycia.

Niestety, w praktyce tak się nigdy nie stanie. Powodem jest to, że każdy nowoczesny wyświetlacz działa ze stałą częstotliwością odświeżania 60 herców (chociaż w niektórych monitorach częstotliwość wynosi 120-144 Hz). Jednak liczba klatek na sekundę musi się różnić, to znaczy, że wskaźnik ten nie może być stały. Na przykład w grze z otwartym światem ten sam system może generować ponad 50 klatek w pomieszczeniu (tj. Wydajność zbliżona do pożądanych 60 klatek na sekundę), ale w otwartych lokalizacjach wskaźnik może szybko spaść do 30-40 klatek na sekundę. W słabych konfiguracjach różnica między częstymi aktualizacjami wyświetlacza a liczbą klatek na sekundę będzie jeszcze większa.

Problem dodatkowo komplikuje fakt, że liczba klatek w dużej mierze zależy od wybranego poziomu ustawień grafiki i rozdzielczości w grze. Na przykład, pewna konfiguracja może zagwarantować 50-60 fps i stosunkowo wygodną grę o rozdzielczości 1280 x 720 pikseli i średnim poziomie szczegółowości. Warto jednak zwiększyć rozdzielczość do Full HD (1920 x 1080 pikseli), a parametry wizualne do poziomu Ultra, a wydajność „spadnie” do 10-20 klatek na sekundę, co w praktyce sprawi, że gra będzie „niemożliwa do odtworzenia”.

Rozwiązywanie problemów

Do niedawna tradycyjną odpowiedzią na problemy z synchronizacją między monitorem a komputerem (karta graficzna) była V-Sync. Innymi słowy, synchronizacja pionowa. Jest to prymitywny, ale stosunkowo skuteczny sposób, który w praktyce powoduje synchronizację silnika gry z częstotliwością odświeżania ekranu..

Niestety, to rozwiązanie ma jedną poważną wadę: działa poprawnie tylko wtedy, gdy każda następna klatka jest renderowana w czasie krótszym niż 1/60 sekundy. Jeśli przygotowanie ramki trwa dłużej, to w następnym cyklu aktualizacji wyświetlacza po prostu nie będzie on gotowy do wizualizacji. W związku z tym karta wideo będzie musiała ją ponownie zwizualizować. Niestety dzieje się tak w przypadku większości nowoczesnych kart graficznych - nawet najwyższej klasy, a widocznym rezultatem tego wszystkiego są irytujące opóźnienia obrazów i inne nieprzyjemne skutki uboczne.

To tutaj NVIDIA ingeruje w ideę tak zwanej „synchronizacji adaptacyjnej”, która w ich przypadku stała się znana jako G-Sync. Jest to przeciwieństwo V-Sync, która zmusza monitor do synchronizacji z grą, a nie odwrotnie. Zatem nawet jeśli sprzęt (karta wideo) jest w stanie zapewnić, powiedzmy, 30 klatek na sekundę, nie będzie to szczególnym problemem, ponieważ wyświetlanie systemu zostanie zsynchronizowane z nim i będzie działać z częstotliwością odświeżania 30 Hz.

Ta technologia może okazać się manną z nieba dla wszystkich graczy, a zwłaszcza dla tych, którzy grają na laptopach, które tradycyjnie oferują mniejszą wydajność niż komputery stacjonarne..

Nie tylko profesjonaliści

Na papierze G-Sync brzmi wspaniale i może oferować wysokiej jakości gry nawet na słabych laptopach, które w przeciwnym razie mogłyby tylko pomarzyć o pożądanych 60 klatkach na sekundę. W praktyce jednak wszystko nie jest takie proste - szczególnie w odniesieniu do implementacji G-Sync na komputerach mobilnych.

Problem polega na tym, że do wdrożenia synchronizacji adaptacyjnej monitor komputera potrzebuje dodatkowego modułu, który dynamicznie dostosowuje częstotliwość odświeżania zgodnie z liczbą klatek na sekundę. Ten moduł jest drogi i, co gorsza, wymaga dużo energii, co czyni go nieodpowiednim dodatkiem, przynajmniej w laptopach, dla których problemy związane ze zużyciem energii są szczególnie bolesne.

Tak jest w przypadku G-Sync w 2013 roku, kiedy NVIDIA po raz pierwszy ogłosiła tę technologię. Niemniej jednak firma nadal aktywnie pracowała nad opracowaniem koncepcji synchronizacji adaptacyjnej, w wyniku czego Mobile G-Sync, rodzaj oryginalnego pomysłu zaprojektowanego specjalnie do użytku na laptopach, został niedawno wprowadzony na świat.

Mobilna g-synchronizacja

Główną zaletą modyfikacji nowej technologii jest brak potrzeby posiadania osobnego modułu synchronizacji sprzętowej. Zamiast tego Mobile G-Sync wykorzystuje możliwości jednego z najnowocześniejszych interfejsów - wbudowanego DisplayPort (eDP), który jest wyposażony w większość laptopów nowej generacji.

W wersji mobilnej G-Sync zapewnia oprogramowanie zamiast sprzętowej metody synchronizacji adaptacyjnej. Opiera się na złożonym algorytmie matematycznym, który próbuje z dużą dokładnością przewidzieć zdolność karty wideo do przygotowania kolejnej klatki przeznaczonej do wizualizacji, a biorąc to pod uwagę, dostosowuje częstotliwość odświeżania wyświetlacza.

Oczywiście osiągnięcie 100% dokładności w tym przypadku jest niemożliwe, ale nawet przybliżony wynik daje poważne odbicie w jakości gry..

Zalety Mobile G-Sync są oczywiste: płynniejsze odtwarzanie, nawet przy słabej konfiguracji sprzętowej, bez zwiększania zużycia energii. Niestety technologia ma jednak swoje słabości. Jak już wspomniano, osiągnięcie absolutnej dokładności w prognozowaniu ramek nie jest możliwe. Z tego powodu algorytm częściowo poświęca dokładność kolorów ze względu na stałą częstotliwość odświeżania i płynniejsze odtwarzanie.

Bardziej nieprzyjemnym efektem ubocznym praktycznego wdrożenia tej technologii jest to, że Mobile G-Sync i NVIDIA Optimus wzajemnie się wykluczają. Jak zapewne wiesz, ta ostatnia jest popularną funkcją, która umożliwia dynamiczne przełączanie między zintegrowanym rdzeniem graficznym w centralnym procesorze a dyskretną kartą graficzną (GeForce). Dlatego podczas pracy z lekkimi zadaniami, takimi jak przeglądanie Internetu i edycja dokumentów, laptop może korzystać ze zintegrowanego wideo, które zużywa znacznie mniej energii niż dyskretny adapter graficzny.

Aby jednak Mobile G-Sync działał, wyświetlacz laptopa musi być podłączony bezpośrednio do oddzielnej karty graficznej (oczywiście z marką NVIDIA). W praktyce wyklucza to udział zintegrowanego rdzenia graficznego w procesorze i sprawia, że Mobile G-Sync i Optimus wykluczają się wzajemnie..

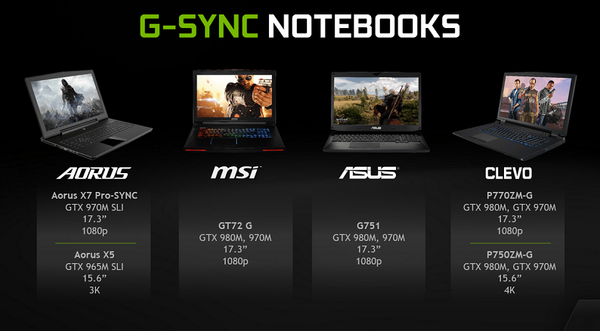

Według NVIDII nie jest to poważny problem, szczególnie w przypadku modeli laptopów z nową generacją procesorów graficznych - Maxwell, które są wyjątkowo energooszczędne. Jest to jednak ważny kompromis, który wielu partnerów OEM będzie musiało zrobić, jeśli zdecyduje się zaoferować Mobile G-Sync jako opcję w swoich laptopach do gier nowej generacji..

Oczywiście przy braku niezależnych testów wciąż nie jest jasne, jak duży będzie ten kompromis i do jakiego stopnia korzystanie z Mobile G-Sync z powodu Optimusa wpłynie na żywotność baterii.

Innym pytaniem jest to, że nawet najbardziej zaawansowane modele laptopów nie mogą zaoferować szczególnie imponującej autonomii - szczególnie na tle ultra wydajnych systemów mobilnych, takich jak ultrabooki najnowszej generacji.

Ale biorąc pod uwagę fakt, że mówimy o wysoce wyspecjalizowanych konfiguracjach przenośnych przeznaczonych dla określonych odbiorców (graczy), którzy preferują najwyższą wydajność, taka ofiara pod względem żywotności baterii nie może być śmiertelna, jeśli Mobile G-Sync spełnij obietnicę zapewnienia naprawdę znacznego wzrostu jakości gry.

Miłego dnia!