Czy pamiętasz, kiedy pojawiły się pierwsze tak zwane procesory wielordzeniowe? Prawie 15 lat temu! Wywodziły się z beznadziejności, jaką doprowadziła tak zwana „wojna megahercowa” - od dawna rywalizacja między dwoma głównymi konkurentami na rynku mikroprocesorów - Intelem i AMD. Przez wiele lat główną miarą sukcesu w tym wyścigu była częstotliwość taktowania chipów, a zasada brzmiała: „im więcej, tym lepiej”.

Na początku nowego wieku w obu obozach stało się jasne, że wkrótce „pompowanie” megaherców stanie w obliczu nie do pokonania ściany ograniczeń technologicznych i przestanie być źródłem paliwa dla tak zwanego „prawa Moore'a”. Rozwiązaniem tego problemu były wielordzeniowe - mikroukłady z dwoma lub więcej rdzeniami na tym samym krzemowym waflu, które pracują równolegle, dzięki czemu osiągają wyższą wydajność.

Teoretycznie takie podejście wydawało się znacznie bardziej rozsądne i skuteczne - zamiast ciągłego zwiększania częstotliwości taktowania, co prowadzi do znacznego wzrostu wytwarzania ciepła i zużycia energii, musisz połączyć kilka rdzeni w jednym układzie scalonym, które będą dzielić czasochłonne obliczenia, aby zrobić więcej praca na jednostkę czasu.

Niestety rzeczywistość okazała się nieco mniej optymistyczna - aby uzyskać pożądany efekt, możliwość równoległego działania powinna być obsługiwana nie tylko przez sprzęt (układ wielordzeniowy), ale także przez oprogramowanie - w szczególności system operacyjny i aplikacje.

Niestety, nawet dzisiaj, 15 lat po pojawieniu się pierwszych komercyjnych wersji procesorów z dwoma lub więcej rdzeniami, wciąż jest wiele życzeń w tej sprawie. Chociaż obsługa wielu rdzeni na poziomie systemu operacyjnego od dawna jest faktem, aplikacje, które w pełni korzystają z równoległego przetwarzania informacji, są nadal stosunkowo niewielkie. Nie jest to oczywiście zaskakujące - w świecie zaawansowanych technologii sprzęt tradycyjnie wyprzedza oprogramowanie o co najmniej trzy okrążenia. W związku z tym powstaje interesujące pytanie dla użytkowników: „Po co kupować powiedzmy czterordzeniowy procesor, jeśli w praktyce zapewni on dokładnie taki sam poziom wydajności jak opcja dwurdzeniowa?”

Sytuacja staje się jeszcze bardziej interesująca, jeśli weźmiemy pod uwagę dość poważne różnice w szybkości między procesorami najnowszej generacji firmy Intel i AMD. W testach porównawczych często okazuje się, że układ AMD z 6 lub nawet 8 rdzeniami jest mniej wydajny niż 4-rdzeniowy procesor Intel.

Różnice te są szczególnie wyraźne, jeśli chodzi o nowoczesne aplikacje, a mianowicie gry komputerowe, które nakładają wyjątkowo wysokie wymagania sprzętowe.

Sytuacja na rynku gier komputerowych sprawia, że karta graficzna w konfiguracji komputera jest znacznie ważniejsza dla wydajności gier niż procesor centralny.

Powodem tego jest w dużej mierze fakt, że najbardziej masywny interfejs programowy, który zapewnia akcelerację 3D na komputerze z systemem Windows - DirectX - został zaprojektowany tak, aby w pełni wykorzystać możliwości GPU. Jeśli chodzi o procesor centralny - stosunkowo mało uwagi poświęca się jego użyciu i często różnica w wydajności między jednym układem a drugim (szczególnie jeśli mówimy o modelach jednego producenta) jest nieznaczna.

Na szczęście dzięki nowej wersji DirectX 12, która będzie jedną z najważniejszych ulepszeń w systemie Windows 10, Microsoft to zmieni. Nawet po wstępnym ogłoszeniu systemu operacyjnego firma podkreśliła, że zmiany są znaczące, a w szczególności wpływają na wykorzystanie wszystkich dostępnych rdzeni procesorów. W obecnej wersji interfejsu wzrost wydajności w trybie jedno- i wielowątkowym jest minimalny. Innymi słowy, DirectX stosunkowo słabo rozdziela zadania między rdzeniami procesora. W rezultacie jeden z nich może być obciążony w 80-100%, a reszta jest po prostu nieaktywna. Z DirectX 12 to się zmieni - Microsoft obiecuje wzrost wydajności nawet o 50%.

To bardzo dobra wiadomość, ponieważ oznacza bezpłatną aktualizację - tj. tylko po przejściu na nową wersję DirectX (a zwłaszcza Windows) użytkownicy uzyskają nawet o 50 procent wyższą wydajność w grach na komputerach z kartami wideo obsługującymi DirectX 11. Teoretycznie to brzmi świetnie, ale jak to w praktyce?

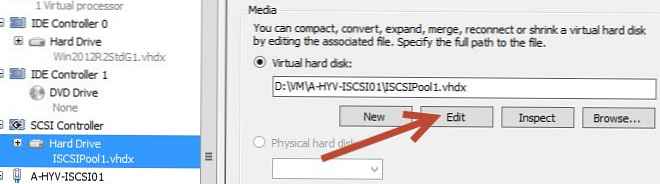

Ulepszone możliwości DirectX 12 zaczęły nabierać wyraźnych linii w zeszłym tygodniu, kiedy Futuremark wydał interesujący dodatek do najpopularniejszego testu syntetycznego 3D Mark. Został zaprojektowany tak, aby w pełni wykorzystać możliwości nowego systemu Windows 10 i wbudowanego w nim DirectX 12..

Zasada działania modułu testowego jest stosunkowo prosta - wymaga, aby centralny procesor narysował na ekranie konkretną figurę geometryczną. Polecenie przechodzi przez interfejs programu (DirectX) i jest przesyłane z centralnej do GPU.

Obciążenie stopniowo rośnie, a końcowy wynik testu pokazuje, ile geometrycznych kształtów zostało narysowanych, zanim liczba klatek na sekundę spadła poniżej krytycznego minimum 30 klatek na sekundę niezbędnego do wygodnej gry.

Futuremark podkreśla, że jest to test, który koncentruje się wyłącznie na użyciu procesora centralnego i który prawie całkowicie ignoruje dostępny układ graficzny. Tj. nowy moduł nie może i nie powinien być używany do porównywania wydajności procesorów wideo.

Wyniki testu przeprowadzonego na komputerze do gier klasy średniej, który korzysta z czterordzeniowego procesora Intel, wygląda niezwykle interesująco. Pokazują nie tylko oczywistą, ale miażdżącą przewagę nowego DirectX 12 nad starą 11. wersją, ponieważ wzrost wydajności jest mierzony nie w procentach, ale w dziesiątkach!

Nie mniej interesujące są testy procesorów o różnych prędkościach zegara i liczbie rdzeni. Dobrze wiadomo, że niższej klasy układ pracujący ze zwiększoną częstotliwością taktowania może wykazywać tę samą lub nawet wyższą wydajność w porównaniu z wyższej klasy procesorem pracującym z częstotliwością nominalną. DirectX 12 to zmieni, ponieważ nowy interfejs oprogramowania daje widoczną przewagę większej liczbie rdzeni, a nie częstotliwości zegara.

To wspaniała wiadomość dla właścicieli wielordzeniowych procesorów AMD. W obecnej sytuacji nie jest tajemnicą, że nawet 8-rdzeniowy układ AMD FX-8370 (Vishera) jest gorszy w niektórych innowacjach w grach od zwykłego dwurdzeniowego procesora Intel Core i3-4360. Jednak dzięki efektywnemu wykorzystaniu wszystkich 8 rdzeni, DirectX 12 może wyrównać sytuację, a nawet dać AMD przewagę nad konkurencją.

Oczywiście wszystkie te dane są całkowicie wstępne. Co więcej, są one wynikiem testów syntetycznych i nie odzwierciedlają rzeczywistej sytuacji, ponieważ, jak wiadomo, na rynku nie ma jeszcze gier DirectX 12.

Dopiero po ich wydaniu otrzymamy ostateczną odpowiedź na dwa ważne pytania: „Czy nowy interfejs oprogramowania naprawdę wnosi tak znaczącą poprawę wydajności gry?” oraz „W jaki sposób i jak dobrze twórcy gier poradzą sobie z implementacją podstawowych funkcji procesora oferowanych przez DirectX 12?”

Miłego dnia!